非监督学习

非监督学习是一种机器学习方法,不依赖于标注数据集(即没有预先定义的目标变量)。在非监督学习中,常见的任务包括聚类和降维。以下是对两类任务中常用算法的详细介绍:

聚类算法

聚类算法的目标是将数据集中的样本划分为若干个组(簇),使得同一簇内的样本具有较高的相似性,而不同簇之间的样本差异较大。

K-means 聚类

概述:K-means 是一种广泛使用的聚类算法,旨在将数据集划分成 K 个簇,每个簇通过其簇中心(质心)表示。

算法步骤:

- 初始化:随机选择 K 个初始质心。

- 分配簇:将每个样本分配到离它最近的质心所在的簇。

- 更新质心:重新计算每个簇的质心,质心为簇内所有样本的平均值。

- 重复步骤 2 和 3,直到质心不再变化或达到最大迭代次数。

优点:

- 简单易懂,计算速度快。

- 对大数据集也能高效执行。

缺点:

- 需要预先指定 KKK 的值。

- 对初始质心敏感,可能陷入局部最优解。

- 只适用于凸形簇,不能处理复杂形状的簇。

层次聚类

概述:层次聚类算法通过构建层次结构(树状结构)来实现聚类,分为自底向上(凝聚层次聚类)和自顶向下(分裂层次聚类)两种方法。

优点:

- 不需要预先指定簇的数量 KKK。

- 能够生成不同层次的聚类结果,可以通过树状图(树状结构)进行观察。

缺点:

- 计算复杂度高,对大数据集不适用。

- 对噪声和离群点敏感。

DBSCAN(密度聚类)

概述:DBSCAN(Density-Based Spatial Clustering of Applications with Noise)是一种基于密度的聚类算法,通过寻找密度相连的点来形成簇。

优点:

- 不需要预先指定簇的数量 KKK。

- 能够发现任意形状的簇。

- 对噪声和离群点具有鲁棒性。

缺点:

- 对参数(如最小点数和半径)的选择敏感。

- 在处理不同密度的簇时表现较差。

降维技术

降维技术的目标是将高维数据映射到低维空间,以减少数据的维度,同时尽可能保留数据的结构和特征。

主成分分析(PCA)

概述:PCA 是一种线性降维技术,通过将数据投影到一组正交基上,以最大化投影后的方差。

算法步骤:

- 标准化数据:将数据中心化,使得每个特征的均值为零(每个特征数据减去均值)。

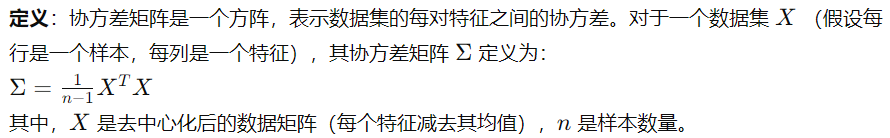

- 计算协方差矩阵:计算数据的协方差矩阵。

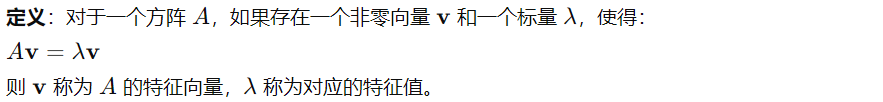

- 特征值分解:对协方差矩阵进行特征值分解,得到特征值和特征向量。

- 选择主成分:选择具有最大特征值的前 K 个特征向量作为主成分,构成新的低维空间。

优点:

- 简单易懂,计算效率高。

- 能够有效降低维度,同时保留数据的主要信息。

缺点:

- 仅能捕捉线性关系,无法处理非线性数据。

- 结果不易解释,难以理解每个主成分的具体含义。

t-SNE(t-distributed Stochastic Neighbor Embedding)

概述:t-SNE 是一种非线性降维技术,特别适合于高维数据的可视化,通过保留相似样本之间的距离来映射到低维空间。

算法步骤:

- 计算高维空间中的相似性概率:基于高维空间中每个点的邻居分布,计算相似性概率。

- 构造低维空间中的相似性概率:在低维空间中构造相似性概率,尽量使其与高维空间中的相似性概率匹配。

- 最小化KL散度:通过梯度下降法最小化高维和低维空间之间的相似性概率的KL散度。

优点:

- 能够有效捕捉复杂的非线性关系。

- 特别适用于高维数据的可视化。

缺点:

- 计算复杂度高,难以处理大规模数据集。

- 对参数(如困惑度)敏感,需调参。

其他常用降维技术

- 核PCA:将数据映射到高维空间,然后在高维空间中进行PCA,适合处理非线性数据。

- 独立成分分析(ICA):用于寻找相互独立的成分,适合用于信号分离等任务。

- 多维尺度分析(MDS):通过保留样本之间的距离关系来实现降维,适用于各种数据类型。

这些非监督学习的聚类和降维技术在数据分析、可视化和预处理方面都有广泛的应用。选择合适的算法取决于具体的应用场景、数据特点和任务需求。

注:

正交基是线性代数中的一个重要概念,指的是一个向量空间中的一组基向量,这些基向量彼此正交且每个向量都是单位向量。正交基在数学和工程应用中有广泛的用途,特别是在简化向量和矩阵的计算时。为了更好地理解正交基,下面是一些关键点的解释:

正交向量

定义:两个向量 u 和 v 在向量空间中是正交的,如果它们的内积(点积)为零: u⋅v=0

单位向量

定义:一个向量 v 是单位向量,如果它的范数(长度)为1:||v||=1

正交基

定义:在向量空间中,如果一组基向量彼此正交且每个向量都是单位向量,那么这组基向量称为正交基。

点积(内积)

点积是两个向量相乘的一种方式,结果是一个标量。点积主要用于度量两个向量的相似性。

定义: 设 a 和 b 是 n 维向量: a=[a1,a2,…,an], b=[b1,b2,…,bn]

它们的点积定义为: a⋅b=a1b1+a2b2+⋯+anbn

或者使用向量的长度和夹角: a⋅b=||a|| ||b|| cos(θ)

其中 θ 是两个向量之间的夹角。

性质:

点积是交换的:a⋅b=b⋅a

点积为零:如果 a⋅b=0,则 a 和 b 正交。

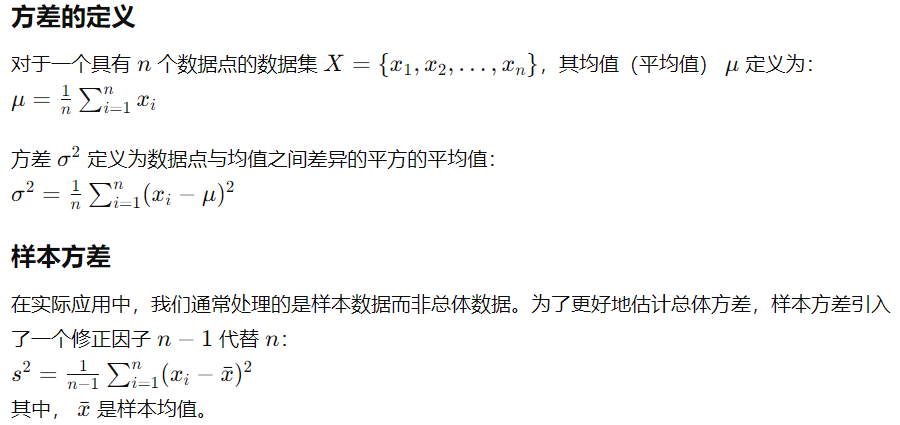

方差

是统计学中的一个基本概念,用于衡量数据集的分散程度。它描述了数据点与其均值之间的偏离程度,即数据点在其均值周围的离散程度。方差的值越大,数据点分布得越分散;方差的值越小,数据点分布得越集中。

协方差矩阵

特征值和特征向量 在线性代数中有介绍

Comments ()